© Сергей Яковлев, 2008

Использование этой информации в коммерческих целях запрещенно. Но Вы можете копировать и перерабатывать данную статью в научных и образовательных целях, с последующим предоставлением результата на тех же правах. Для подробной информации см. Авторское право.

Исследование принципа рефрактерности в рекуррентных нейронных сетях[]

Sergey Jakovlev, Mg.sc.comp., Institute of Information Technology, Riga Technical University, 1 Meza Street, Latvija, e-mail: sergeyk@fis.lv, tac@inbox.lv

Аннотация. В работе показана возможность совмещения перцептрона Розенблата и сети Джордана, в результате чего перцептрон приобретает обратные связи, а обучение остается таким же быстрым и эффективным, как в перцептроне Розенблата. В работе также показана особая роль моделирования рефрактерности в ассоциативных элементах, что позволяет сети быстро запоминать последовательности внутренних состояний. Это происходит благодаря тому, что процесс рефрактерности автоматически регулирует нагрузку, которая ложится на ассоциативные элементы, выбирая группы, которые не были еще задействованы. А это в свою очередь и определяет дифференциацию сети на ряд малосвязанных нейронных ансамблей и отличает от классического перцептрона, у которого отсутствует управление числом одновременно активных ассоциативных элементов. Полученный таким образом перцептрон Yak-2 протестирован на задаче обучения агента, помещенного в модельную среду.

Keywords: perceptron, recurrent neural networks, refractory period

Введение[]

Представленный в работе вид искусственной нейронной сети (ИНС) – перцептрон Yak-2 является развитием идей о рекуррентном перцептроне, изложенных ранее в [1]. Основным достижением предшествующей работы является, то что стало возможным использовать алгоритм коррекции ошибки как в перцептроне Розенблата, но для рекуррентный сетей. Это в свою очередь позволило отказаться от алгоритма обратного распространения ошибки [2, 3], который сталкивается с серьезными скоростными ограничениями, в результате чего его нельзя использовать в задачах с большой размерностью.

В настоящей статье рассмотрено моделирование принципа относительной рефрактерности. В электрофизиологии относительным рефрактерным периодом (рефрактерностью) называют временной интервал, в течение которого возбужденные нейроны постепенно восстанавливает способность формировать потенциал действия (стимул). В ходе относительного рефрактерного периода стимул, более сильный, чем тот, который вызвал первую активацию нейрона, может привести к формированию повторной активации нейрона. Качественная модель принципа рефрактерности описана ранее в составе описания идей о синергетически активных нейронных моделях [4]. Далее рассмотрен описанный в упомянутой работе принцип относительной рефрактерности и показано, что его нельзя использовать в отрыве от архитектуры ИНС. Но так как рефрактерность имеет важную роль в биологических организмах, будет показано, при каких условиях моделирование этого принципа и при какой архитектуре ИНС может быть выгодно информационно и как оно используется в перцептроне Yak-2.

Устройство перцептрона Yak-2[]

Имеет смысл вначале напомнить архитектуру рекуррентного перцептрона Yak-1, так как у перцептрона Yak-2 она схематически не отличается (рис. 1б). Такая архитектура получается, если перцептрон Розенблата [5] наделить обратными связями и контекстными рецепторами сети Джордана [6]. При этом обучение происходит не по алгоритму обратного распространения ошибки как в сети Джордана, а по алгоритму коррекции ошибки как в перцептроне Розенблата. Основным отличием перцептрона Yak-2 является, то что в нем реализуется принцип рефрактерности. Ниже приведены формальные определения, дополняющие описаные ранее в [1].

Определение 1. Рекуррентным перцептроном Yak-1 называется система, удовлетворяющая следующим условиям:

- Система состоит из бинарных S, Sin , A и R - элементов;

- Система представляет собой перцептрон с последовательными связями, идущими только от S-элементов (и Sin – элементов, группы которых разделены на модальности) к А - элементам и от А - элементов к R-элементам;

- Система обладает обратными связями с единичной задержкой во времени от R-элемента к Sin-элементам, с помощью которых R-элементы могут воздействовать на Sin -элементы в следующий момент времени;

- Веса всех связей S-элементов и Sin – элементов к А - элементам являются фиксированными (не изменяются в процессе обучения) и выбираются один раз случайным процессом с определенной функцией распределения;

- Веса всех связей от А - элементов к R-элементам являются переменными и настраиваются в процессе обучения методом коррекции ошибки;

- Число связей S-элементов и Sin – элементов к А - элементам определяется числом d, которое существенно меньше общего количества сенсорных элементов и выбрано для каждой из модальностей. Общее число входных связей А - элемента будет равно сумме чисел d, выбранных для каждой из модальностей. Связи А - элементов к R – элементами определяются силой связи, которая определяется при обучении и в ряде случаев может быть равной нулю, т.е. отсутствовать;

- Время внутренней обработки сигнала синхронизируется с определенной частотой , а внутренняя обработка занимает некоторое время, которое соответствует длине запоминаемой последовательности пар стимул-реакция. А внутрения обработка одной пары стимул-реакция равна одному такту работы сети;

- Обучение может быть разделено на этапы (см. определение 3).

Определение 2. Перцептроном Yak-2 называется система, удовлетворяющая всем условиям рекуррентного перцептрона Yak-1, но дополнительно каждый ассоциативный элемент обладает периодом рефрактерности, заключающимся в том, что после активации А - элементов порог на время внутренней обработки сигнала увеличивается на определенную величину. А затем за каждую единицу времени внутреней обработки уменьшается по экспоненциальному закону (пример затухания периода рефрактерности см. на рис. 1б справа внизу). При приеме нового внешнего сигнала с частотой пороги всех ассоциативных элементов устанавливаются равное нулю.

Определение 3. Этапом обучения назовем процесс осуществления обучения сети с одним подмножеством обучающей выборки, которую предоставляет экспериментатор для обучения агента. Разделение обучения на этапы позволяет получать информацию некоторыми осмысленными порциями. При следующем этапе сеть уже находится в частично обученном состоянии.

Пример использования перцептрона Yak-2[]

Задача обучения агента[]

Рис. 1а. Пример входных-выходных данных (пары стимул-реакция)

В искусственном интеллекте существует понятие обучающегося интеллектуального агента - в нашем случае, это программная система, наблюдающая за модельной средой, способная к обучению и приспосабливанию к изменяющимся условиям. Чтобы активно выполнять свои функции, агент обычно имеет иерархическую структуру, включающую много «субагентов». Будет рассмотрена работа только сенсорного субагента (далее просто агент), который на основе сенсорных сигналов создает свою «картину мира».

Агент использует механизм перцептрона Yak, что даёт ему возможность реагировать на информацию в модельной среде и необходимую запоминать. В экспериментах сравним первую версию рекуррентного перцептрона Yak и описываемую здесь рефрактерного перцептрона Yak. В работе не рассматривается поведение агента на основании анализа полученной им информации, а вместо этого уделяется внимание лишь процессу обучения с подкреплением, скорости этого процесса и некоторым его характеристикам.

Модельная среда представляет собой карту местности (рис. 1б, слева внизу), разделенную на 276 квадратов (участков) различного типа – луг, равнина, океан, река и т.д. (всего 20 видов). Каждый тип территории отличается количеством ресурсов, которые можно получить, обрабатывая эту территорию. Различают четыре вида ресурсов – пища, металл, золото, скорость перемещения возможного объекта по местности.

В процессе обучения агент проходит все позиции на карте. Во время первого этапа агент обходит последовательно внешние 10 позиций по оси X и 15 позиций по оси Y – всего 1350 позиций (координаты отмечены белым цветом на рис. 1б). А во время второго этапа агент обходит последовательно внутренние 9 позиций по оси X и 14 позиций по оси Y – всего 1134 позиций (координаты отмечены серым цветом на рис. 1б).

В процессе прохождения агентом позиций в модельной среде, он формирует таким образом обучающую выборку, которая состоит из набора соответствий стимул – реакция (рис. 1а). Где в качестве стимула используется визуальное изображение 9-ти окружающих агента участков (один участок имеет размер 64х32 пикселей с 256 цветовой гаммой) (см. рис. 1б, слева посередине – увеличенная часть карты местности), а учитель тренирует агента создавать соответствующие смысловые реакции.

Информация предоставляемая учителем во время обучения и затем требуемая на выходе состоит из трех составляющих:

- Типы территории, окружающие агента;

- Количество одинаковых территорий определенного типа (количество лугов, равнин, океанов, рек и т.д.), окружающих агента. Такая совокупность образет 20 чисел – по одному числу на каждый тип территории;

- Количество ресурсов, имеющихся на исследуемой агентом области, таким образом, создаётся маска ресурсов, состоящая из 3 чисел (количество пищи/ металла/золота), характеризующих общее количество ресурсов в прилегающей области нахождения агента.

В процессе внутреней обработки нужно накапливать информацию, сохраняя в памяти для одновременного анализа до 9 типов территорий, таким образом, имея в качестве внутренних состояний информацию обо всей окружающей агента области. Пример таких входных-выходных данных показан на рис. 1а.

Результаты моделирования[]

Разработанная программа выполнена на одном виртуальном процессоре четырехядерного процессора Xeon E5310 под ОС Windows Vista x86. При этом системой использовалось 800-950 Мб оперативной памяти из 2 Гб имеющихся. Число А - элементов находится в зависимости от общего числа стимулов, необходимых для запоминания (2484) и составляет, как правило, 60-80% от этого числа. В тестовой задаче обучение проводится в два этапа (1350+1134 стимулов) и тестируется на двух случаях с 1500 А - элементов (нижняя граница) и 2000 А - элементов (верхняя граница). Таким образом, проведенно четыре различных эксперимента, результаты которых обобщены на рис. 2 – 5. Благодаря рекуррентности сети в процессе ее работы образуется 9 внутренних состояний, что определяется длиной последовательностей при определении типа территорий, суммировании количества одинаковых типов территорий и количества ресурсов на них (рис. 1а). А на выход подается уже готовый комплекс информации. В дальнейшем такая информация позволит агенту выбирать направление при поиске оптимального места на карте местности (этот процесс не рассматривается в данной работе).

Таким образом, рекуррентность используется как бы для возможности внутренней обработки информации – восстановлении 9 запомненных ранее однотипных наборов информации о каждом участке. Точнее за каждый такт внутреней обработки может происходить не просто восстановление отдельно взятой информации об участке, а некая операция (например, суммирование) учитывающие предысторию анализа этих 9 участков. Конечно, такие операции просто определены обучением, а не образуются в сети. На внешних сенсорах (на сетчатке) присутствует один и тот же стимул, и благодаря внутренней девятитактной работе получается готовый результат.

Принцип рефрактерности реализуется следующим образом: если А – элемент активизировался, то его порог увеличивается на 100 единиц. За следующую единицу времени внутреней обработки (такт) порог понизится до 81 единицы, т.е. в соответствии с квадратичной зависимостью (9^2 = 81). Далее до 64, 49, 36 и пока не достигнет нуля.

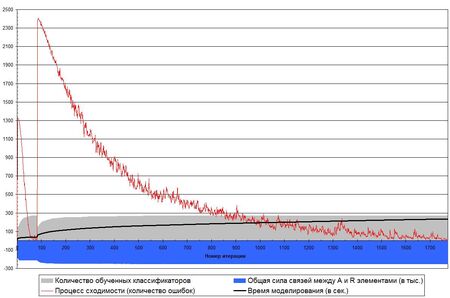

Сравнивая рисунки 2 с 3 и 4 с 5 можно проанализировать разницу между тем, реализуется ли у А – элемента принцип рефрактерности или нет. А сравнивая рисунки 2 с 4 и 3 с 5 увидеть отличие между разным количеством А - элементов. На каждом рисунке показаны четыре кривые, которые позволяют увидеть, как изменяются различные характеристики друг относительно друга в зависимости от количества итераций процесса обучения. При этом по оси Х отложено число итераций, а по оси Y – число имеет различный смысл. Для кривой сходимости – это число ошибок на данной итерации; для кривой скорости обучения – это время, затраченное на моделирование (в секундах) до данной итерации; для кривой обучения классификаторов – это количество обученных классификаторов за время истёкших итераций; для кривой нарастания весовых коэффициентов – это общая сила связей (в тысячах) имеющаяся к данной итерации. Следует отметить, что на графиках хорошо видны различия между первым и вторым этапом обучения (см. определение 3). На первом этапе запоминается половина информации. А в начале второго этапа обучения забывает практически все, чему научилась на первом. На кривой сходимости этапам обучения соответствуют два скачка с последующей сходимостью до нуля. Но если бы информации на каждом этапе добавлялось не так много, то соответственно, и забывание было бы меньшим. Зато обучение с большим числом этапов потребовало бы большего времени. Поэтому информацию эффективнее получать сразу некоторыми порциями (подмножествами обучающей выборки), что аналогично наличию у агента кратковременной памяти, которая затем формирует долговременную память в виде нейросетевой модели «мира» агента. Также можно заметить, что скорость обучения на первом этапе всегда больше, чем на втором. Это связано с тем, что на первом этапе еще много свободной памяти (число А-элементов вдвое больше необходимого количества) – отсюда и стремительное обучение.

Одна из кривых на графиках показывает число обученных классификаторов. Дело в том, что каждый классификатор обучается совершенно независимо (параллельно) от другого. И когда один из классификаторов обучился, то есть его выход всегда соответствует требуемому значению на всех стимулах, то его можно исключить из процедуры обучения. Различные классификаторы обучаются за различное время, что определяется сложностью зависимости реакции от стимула. И чем большее число классификаторов обучено, тем меньшее время будет затрачено на последующую итерацию, что можно видеть на графике. Кривая скорости обучения (в секундах) зависит от числа обученных классификаторов в большей степени, чем от числа ошибок.

Также имеет смысл проследить за общей силой связей между А и R элементами. Существует гипотеза, что она должна постоянно возрастать в зависимости от числа итераций. Такое предположение базируется на том, что Минский в частном примере для задачи на предикат четность, показал [7], что весовые коэффициенты будут неограниченно возрастать. Здесь можно видеть на задаче, на которой делались эксперименты, что общая сила связей возрастает только вначале, а потом на длительном промежутке времени находится практически в стабильном состоянии, имея лишь незначительные колебания. Также можно отметить тот факт, что общая сила связей имеет отрицательный знак. Это означает, что число возбуждаемых связей в каждый момент времени мало, но их силы достаточно, чтобы преодолеть общий фон тормозящего воздействия, то есть в момент поступления стимула происходит резкий точечный всплеск активности. Именно поэтому такой способ обучения является стабильным. Если бы общая сила связей была положительной, то любой незначительный стимул приводил бы в активность большое число элементов и было бы сложно в таких условиях дифференцировать различные стимулы.

Выводы[]

Полученными характеристиками перцептрон Yak-2 обязан в первую очередь эффекту рефрактерности, что можно наблюдать на результатах моделирования. Но применять принцип рефрактерности в свою очередь можно только в рекуррентных сетях, которые обладают рядом характеристик перцептрона Yak-1. Таким образом, данный принцип может принести пользу только в перцептроне с определенной архитектурой, а сам по себе он может не только не принести пользы, но и наоборот привести к тому, что сеть будет неустойчивой, из-за чего время обучения увеличится или не будет сходимости.

Если идеи о принципе рефрактерности применять к ИНС независимо от ее архитектуры, то сеть в процессе обучения будет неустойчивой, и ей нужно будет постоянно переучиваться, так как одновременно будут итерационно изменяться два параметра – пороги и силы связей. И понятно, что теоретически это в лучшем случае займет больше времени (так как на следующей итерации сила связей будет подбираться при других порогах), а практически вероятность сходимости сети будет крайне мала и ухудшается при увеличении размерности сети. Кроме того, такой сети будет небезразлично, в каком порядке воспринимает внешние стимулы, то есть такая сеть не будет универсальной.

Здесь исследователь стоит перед выбором, с одной стороны, нужно отражать зависимость от прошлых состояний, а с другой - должно быть безразлично для классификации, в какой последовательности поступили стимулы. Этот парадокс снимается только рекуррентными сетями и при разделении стимулов на внешние и внутренние. Кроме того, обязательна синхронизация обработки внутренних стимулов, и как следствие, прием с определенной частотой внешних стимулов, и генерирование реакции только в определенные моменты времени (седьмое условие определения перцептрона Yak-1). Это основное отличие от архитектуры ИНС Джордана.

Однако этого недостаточно, чтобы добиться устойчивости при обучении сети, и поэтому нужно отметить еще два нюанса:

- Первый слой должен быть необучаемым, то есть связи от первого слоя не должны изменяться в процессе обучения (четвертое условие определения перцептрона Yak-1). Необходимость этого заключается в том, что неоправданно усложняется обучение – отображение нелинейных данных, поступивших с сенсоров на линейное представление, большей размерности уже произошло, а изменение приведет к тому, что это уже будет другое отображение (ничем не лучше первоначального), что и будет еще одним фактором нестабильности при обучении. Кроме того, это занимает лишнее время моделирования без получения качества.

- Принцип рефрактерности применяется только во время внутренней обработки стимулов. При приеме внешнего стимула пороги устанавливаются в исходное состояние (условие определения перцептрона Yak-2). Необходимость этого заключается в том, что внешние стимулы должны восприниматься независимо от того, в какой последовательности они поступили и какая внутренняя активность сейчас в сети.

Почему же эффект рефрактерности так влияет на скорость обучения? Дело здесь не только в том, что чередуются А - элементы, благодаря чему активные элементы имеют время на фазу покоя после возбуждения. Дело еще в том, что такое чередование позволяет, во-первых, уменьшить число активных А - элементов и, соответственно, корректировать меньшее число весовых коэффициентов. Во-вторых, чередование позволяет лучше сортировать используемые и неиспользуемые А - элементы. Как правило, после случайного выбора фиксированных связей первого слоя активируются очень близкие группы с большим пересечением (так как внешний стимул во время внутренней обработки остается прежним, и дифференциация происходит лишь исходя из внутренних стимулов). Именно эффект рефрактерности уменьшает такое пересечение, позволяет задействовать даже те нейроны, активность которых в обычном случае не внесла бы серьезный вклад, но так как заглушена активность самых сильных нейронов, то настраиваются уже другие весовые коэффициенты. А уменьшение пересечения, как следствие, ведет к тому, что уменьшается эффект забывания при обучении. Поэтому число итераций (а не только времени) в перцептроне Yak-1 требуется меньше.

По сути это более удачная реализация принципа конкуренции нейронов в среднем слое. Для этого в других архитектурах, как правило, вводят тормозящие связи, которые уменьшают возбудимость нейронов, между нейронами среднего слоя. Тогда торможение приводит к увеличению выхода наиболее высокоактивных нейронов за счет соседних. Такие системы увеличивают контрастность, поднимая уровень активности нейронов, подсоединенных к ”яркой” области сетчатки, в то же время еще более ослабляя выходы нейронов, подсоединенных к “темным” областям. Но введение таких связей ресурсоемко и в конечном счете не эффективно. Это происходит из-за того, что если такие связи вводить случайным образом, то нужно проследить за тем, чтобы не образовывались замкнутые контуры (обратные связи), в противном случае нужно следить за устойчивостью системы. А главное введение таких связей в среднем слое в лучшем случае удваивает общее число связей в нейронной сети. В результате эффект который удается выиграть, теряется при расчете активностей нейронов. В то же время для моделирования эффекта рефрактерности достаточно изменить порог А – элемента, без необходимости введения излишних связей и расчетов связанных с ними.

Итак, можно констатировать, что дополнительная реализация принципа рефрактерности в перцептроне Yak-2, позволяет ускорить обучение сети в среднем в 5 раз. При этом в сеть не вводится дополнительные элементы, а просто более эффективно используются имеющиеся ассоциативные элементы. Кроме того, реализация принципа рефрактерности для внутреней обработки не дестабилизирует работу сети. Это означает, что этот принцип может применятся только для рекуррентных сетей у которых есть внутренние состояния. В противном случае, сеть была бы не устойчивой, а следовательно, не пригодной для практического использования.

Список литературы[]

- Яковлев С., Борисов А. (2008) Исследование принципа рекуррентности Джордана в перцептроне Розенблата. http://www.tachome.times.lv/Articles/Yak_1.pdf

- Rumelhart D.E., Hinton G.E., Williams R.J. (1986). Learning internal reprentations by error propagation. Parallel distributed processing, Cambridge, MIT Press.

- Вассерман Ф. (1992). Нейрокомпьтерная техника: теория и практика, Москва, «Мир».

- Шамис А.Л. (2006). Пути моделирования мышления, Москва, «КомКнига», 336 с.

- Проект Википедия – энциклопедия в интернете http://ru.wikipedia.org/wiki/Перцептроны_с_обратной_связью

- Jordan, M. I. (1986). Serial order: A parallel distributed processing approach. Institute for Cognitive Science Report 8604. University of California, San Diego

- Минский М. (1971). Перцептроны, Москва, «Мир».